Detection of Adversarial Training Examples in Poisoning Attacks through Anomaly Detection

Detection of Adversarial Training Examples in Poisoning Attacks through Anomaly Detection abstract。

解决的问题

数据投毒是针对机器学习系统的安全威胁,攻击者可以在训练数据中注入恶意样本来破坏学习过程。

最近在针对机器学习的攻击方面的工作表明,所谓的最优攻击策略可以成功地给线性分类器投毒,改变一小部分训练数据之后可以显著降低系统性能。

Architecture

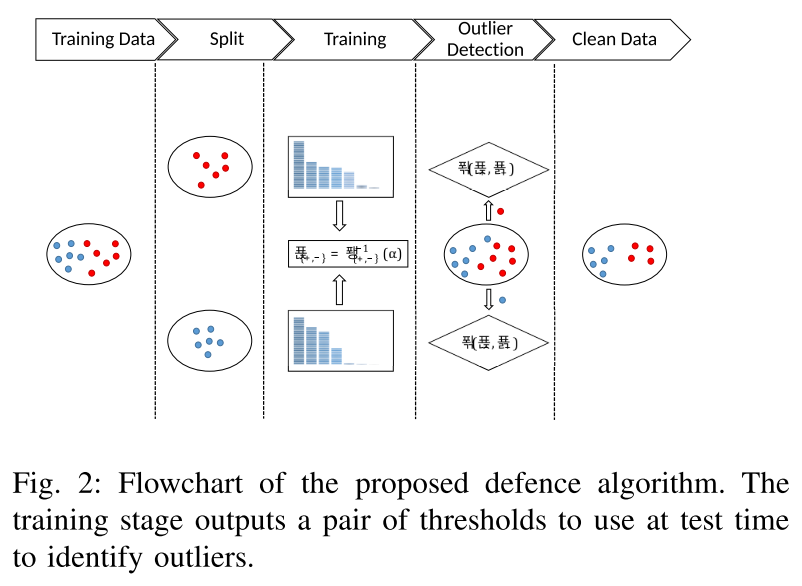

在本文中,提出了一个可以降低基于异常值最佳投毒攻击的防御机制。

思路与步骤

- 从数据集中分离出一部分可信的数据

- 针对每一类训练一个基于距离的异常值检测器

- 给定一个数据集,为其中每个样本计算一个异常值q(x),并基于训练实例分数的经验累积分布函数 Empirical Cumulative distribution Function, ECDF 获得阈值

- 识别真实数据比例 alpha-percentile

All articles in this blog are licensed under CC BY-NC-SA 4.0 unless stating additionally.